本地部署的Dify 除了支持本地部署大模型,其实还有一种更省心的方式:直接通过 API 调用模型供应商提供的大模型,这种方式不用你去折腾本地环境配置,出错的概率低很多,而且还能节省设备的运行空间,非常适合想快速搭建 Agent 的朋友

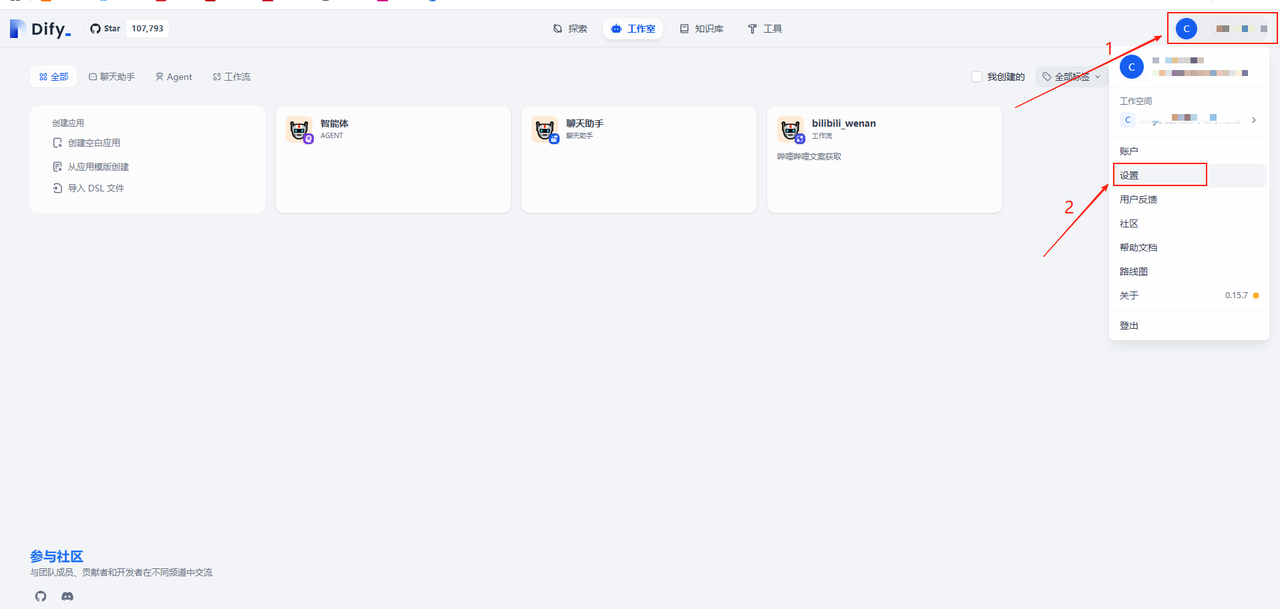

首先点击右上角的用户图标,然后在弹出来的小菜单里点击设置

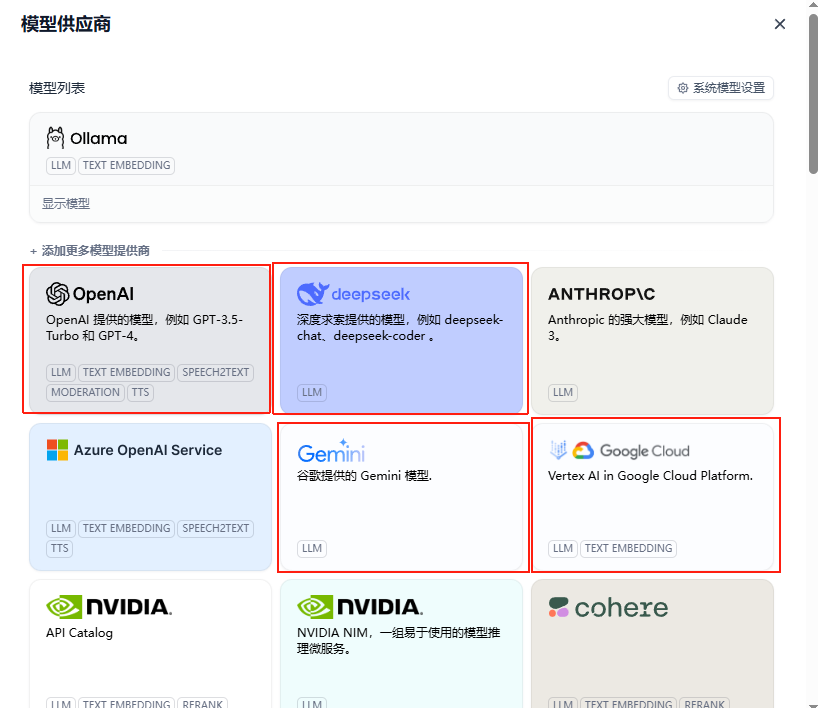

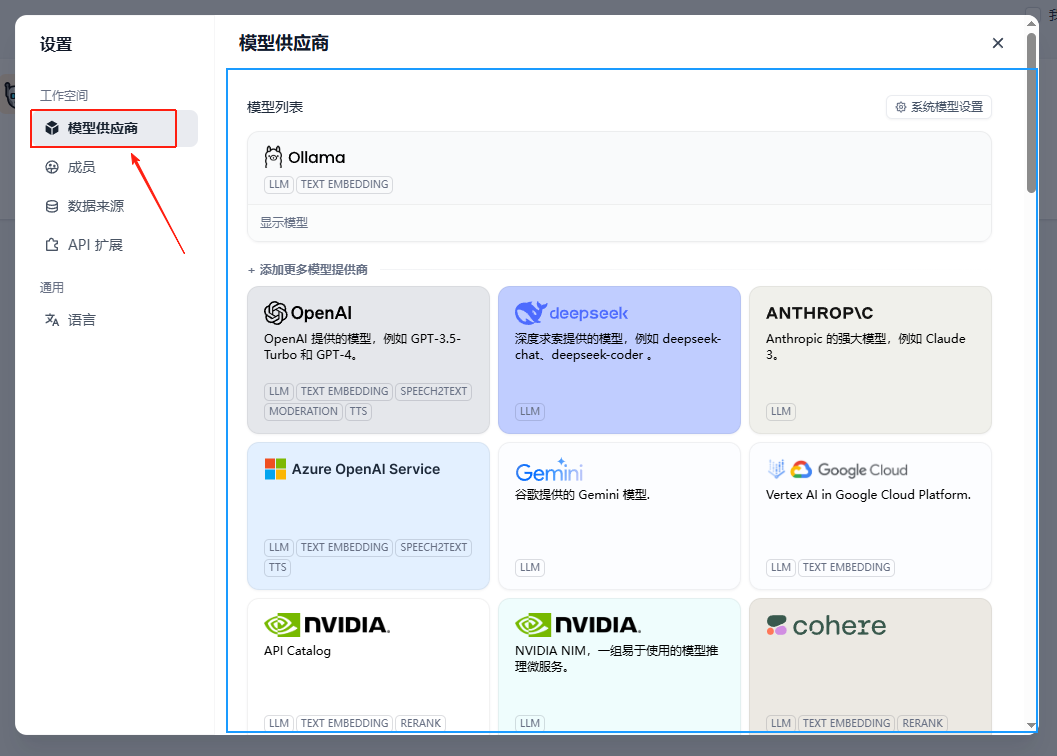

然后点击模型提供商,大家在这个界面选择自己想要使用的模型进行安装部署即可

可以看到我们的模型列表已经有了一个Ollama,这是因为我们在上一篇中完成了本地大模型的部署,感兴趣的朋友可以回到上一节进行本地部署deepseek

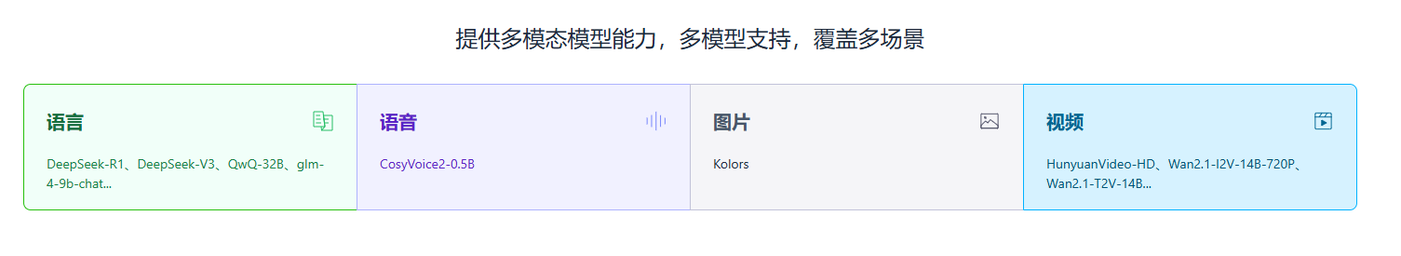

对于刚入门的朋友,我们建议再配置一个 硅基流动 来调用大模型 硅基流动是国内做得比较好的模型供应商之一,模型种类多,包括千问系列等,而且新注册就会赠送一定额度,超过额度后才需要付费,非常适合刚接触 AI 行业的朋友用来练手

https://siliconflow.cn/

进入官网后你会看到,它支持的模型类型很丰富,语音、图片、视频等领域都有云服务

这样我们就可以直接通过 API 调用,把模型应用到日常开发中,非常方便

当然,如果你更想用其他模型供应商也没问题

只需要在 Dify 中点击进行设置,然后去对应官网获取 API-key 即可

比如我们点击 DeepSeek 后,会弹出一个窗口要求填写 API-key。

窗口下方通常会有一个跳转链接,点击它就能进入到获取 API-key 的页面

就目前而言,付费来调用大模型的情况是无法避免的,大家可以根据各方的收费标准酌情选择需要的模型提供商,在本节,我们就以OPEN AI和硅基流动为例,手把手教大家配置一下这两个模型供应商